科学界警告称谨防基于人工智能的欺骗检测

人工智能可能很快就能帮助识别谎言和欺骗。然而,马尔堡大学和维尔茨堡大学的一个研究小组警告不要过早使用。

噢,要是能像匹诺曹那样简单就好了。当他说谎时,很容易看出:他的鼻子每次都会变长一点。事实上,识别谎言要困难得多,科学家长期以来一直在尝试开发有效的欺骗检测方法,这是可以理解的。

现在,人们对人工智能(AI)实现这一目标寄予厚望,例如试图识别在匈牙利、希腊和立陶宛等欧盟边境有犯罪意图的旅行者。

基础研究的宝贵工具

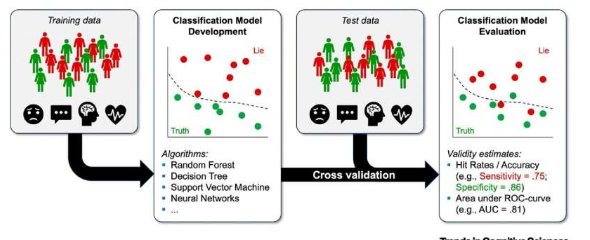

马尔堡大学和维尔茨堡大学的研究人员现在警告不要过早使用人工智能来检测谎言。他们认为,该技术是基础研究的潜在有价值的工具,可以更好地了解欺骗背后的心理机制。然而,他们对其在现实生活中的应用持怀疑态度。

KristinaSuchotzki和MatthiasGamer负责这项研究,该研究现已发表在《认知科学趋势》杂志上。克里斯蒂娜·苏霍茨基(KristinaSuchotzki)是马尔堡大学教授;她的研究重点是谎言以及如何辨别谎言。马蒂亚斯·加默(MatthiasGamer)是维尔茨堡大学的教授。他的主要研究领域之一是可信度诊断。

应用的三个核心问题

Suchotzki和Gamer在他们的出版物中指出了当前基于人工智能的欺骗检测研究中的三个主要问题:测试算法缺乏可解释性和透明度、结果有偏见的风险以及理论基础的缺陷。原因很明确:“不幸的是,当前的方法主要集中在技术方面,而牺牲了坚实的方法和理论基础,”他们写道。

他们在文章中解释说,许多人工智能算法都“缺乏可解释性和透明度”。通常不清楚算法如何得出结果。对于一些人工智能应用,到了一定程度,连开发者都无法清楚地理解判断是如何做出的。这使得无法批判性地评估决策并讨论错误分类的原因。

他们描述的另一个问题是决策过程中出现“偏见”。最初的希望是机器能够克服人类的偏见,例如刻板印象或偏见。然而,实际上,由于人类输入模型的变量选择不正确,以及所使用的数据规模小且缺乏代表性,这种假设常常会失败。更不用说用于创建此类系统的数据通常已经存在偏见。

第三个问题具有根本性:“在测谎中使用人工智能是基于这样的假设:可以识别有效的线索或欺骗所特有的线索组合,”Suchotzki解释道。然而,即使数十年的研究也未能识别出如此独特的线索。也没有任何理论可以令人信服地预测它们的存在。

大规模筛查中极易出错

然而,Suchotzki和Gamer并不建议反对基于人工智能的欺骗检测。最终,该技术是否有潜力提供足够有效的结果是一个实证问题。然而,他们认为,在考虑在现实生活中使用之前,必须满足几个条件。

他们说:“我们强烈建议决策者仔细检查算法的开发是否符合基本质量标准。”先决条件包括受控实验室实验、没有系统偏差的大型且多样化的数据集以及算法及其在大型独立数据集上的准确性的验证。

目的必须是避免不必要的误报,即算法错误地认为自己检测到谎言的情况。使用人工智能作为大规模筛查工具(例如在机场)与将人工智能用于特定事件(例如审问刑事案件中的嫌疑人)之间存在很大差异。

“大规模筛查应用通常涉及非常非结构化和不受控制的评估。这大大增加了假阳性结果的数量,”Gamer解释道。

对政客的警告

最后,两位研究人员建议,基于人工智能的欺骗检测只能在高度结构化和受控的情况下使用。尽管没有明确的谎言迹象,但在这种情况下可以最大限度地减少替代解释的数量。这增加了将行为或陈述内容的差异归因于欺骗企图的可能性。

苏霍茨基和加默补充了他们的建议,并向政治家发出警告:“历史告诉我们,如果我们在现实生活中引入检测欺骗的方法之前不遵守严格的研究标准,将会发生什么。”

测谎仪的例子非常清楚地表明,即使后来积累了低效性和对无辜嫌疑人的系统性歧视的证据,摆脱这种方法是多么困难。

免责声明:本答案或内容为用户上传,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。 如遇侵权请及时联系本站删除。